Ich glaube wir kommen alle nicht mehr an der Künstlichen Intelligenz vorbei.

Du hast eine Frage? – Google ist out, die Frage stellt man der KI.

Du bist alleine und suchst einen Gesprächspartner? – Dein neuer Freund kann die KI sein.

Doch die KI kann noch viel mehr. Zum Beispiel Dokumente analysieren und diese dann Tags zuordnen. Dabei möchte ich nicht, dass meine Dokumente auf irgendwelchen Servern verarbeitet werden. Hier setzt Ollama an. Eine KI die im Heimnetz ihre Anwendung findet und über Schnittstellen genutzt werden kann.

Einige Container bieten KI Integration. Je nach Anwendung kann man unter den Environments diese KI einbinden oder ggf. auch im Menü der GUI. Eine andere Möglichkeit ist z.B. n8n, eine Automatisierungsplattform für Workflows.

Vorraussetzungen

Ich habe Ollama auf meinem Homeserver MINIS FORUM UM450 mit AMD Ryzen 5 4500U 6C/6T mit 4,0 GHz 32 GB RAM genutzt.

Ollama habe ich 5 Kerne über Proxmox gegeben und damit ist die KI an seine Grenzen gekommen. Aus dem Grund nutze ich Ollama bei mir nicht aktiv. Es hat allerdings funktioniert. Man brauch nur Geduld. Falls du es mal testen möchtest kommen wir nun zum Docker Compose File.

Docker Compose File

Ich habe Ollama auf Dockge installiert. Den Code unten eingefügt und gewartet bis die Gigabytes von Images herunter geladen sind. Die open-webui hat auch ein paar Sekunden gebraucht bis sie gestartet ist.

Bei dem Docker Compose Skript handelt es sich um 2 Container. Einmal Ollama selbst und die Web GUI, open-webui. Die Web GUI ist über den Port 8080 erreichbar. Also http://deineIP:8080

networks:

ollama-docker:

external: false

volumes:

ollama: null

open-webui: null

services:

ollama:

container_name: ollama

image: ollama/ollama:latest

networks:

- ollama-docker

expose:

- 11434

volumes:

- ollama:/root/.ollama

restart: unless-stopped

open-webui:

container_name: open-webui

image: ghcr.io/open-webui/open-webui:main

networks:

- ollama-docker

ports:

- 8080:8080

volumes:

- open-webui:/app/backend/data

environment:

- OLLAMA_BASE_URL=http://ollama:11434

restart: unless-stopped

Einstellungen

Einstellen musst du nun nicht mehr viel. Auf der Webseite musst du dich Anmelden. Dabei bleiben deine Daten bei dir.

Im Anschluss kannst du deine Lieblingssprache einstellen. Bei mir als Deutscher, deutsch.

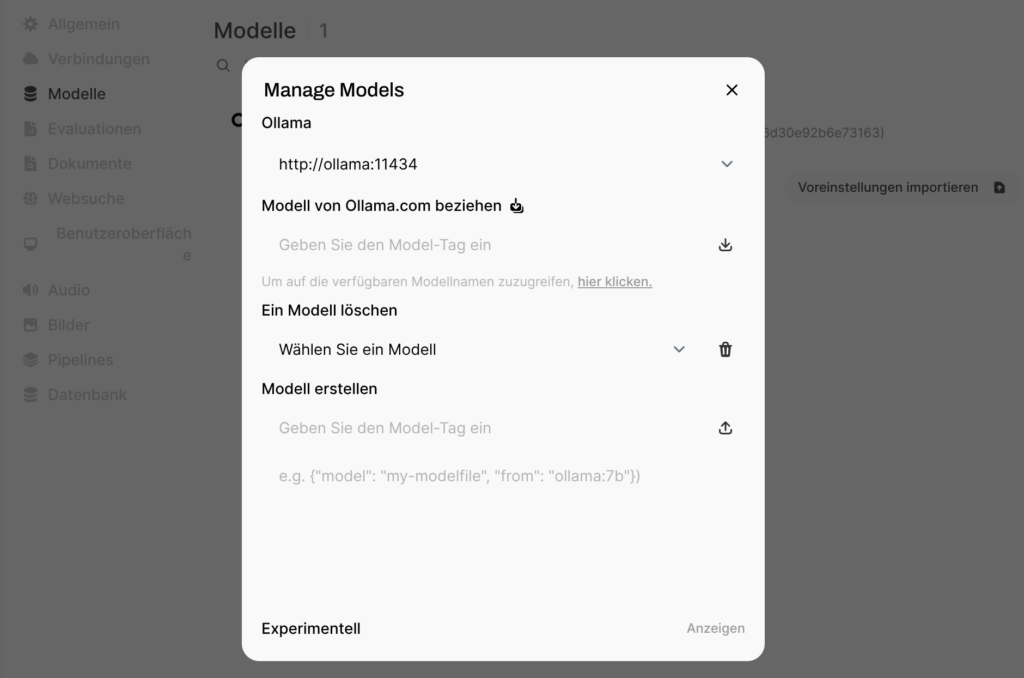

Nun einmal Einstellungen – Administrationsbereich – dort auf Modelle und rechts auf Manage Models. Nun auf „Um auf die verfügbaren Modellnamen zuzugreifen, hier klicken“ klicken. Hier suchst du dir ein Modellname aus. Als beliebte werden mir llama3.3 oder deepseek-r1 angezeigt. Diesen Tag fügst du unter „Modell von Ollama.com beziehen“ ein und wartest bis der Download fertig ist. Das kann dauern. In dieser Datei befindet sich das Wissen.

Viel Spaß beim ausprobieren.

Schreibe einen Kommentar